FPGA在信息系统集成中的低延迟优势探析

在当今高速发展的信息技术领域,低延迟已成为许多关键应用的核心需求,尤其是在金融交易、实时数据处理、电信网络和边缘计算等领域。现场可编程门阵列(FPGA)因其独特的硬件架构,在实现超低延迟处理方面展现出显著优势,常常成为信息系统集成服务中的优选方案。相较于图形处理器(GPU),FPGA在延迟性能上为何能实现数量级的领先?这需要从其设计哲学、工作模式及在系统集成中的角色进行深入分析。

从根本架构上看,FPGA是一种可编程的半导体器件,其内部由大量可配置逻辑块(CLBs)、可编程互连资源和I/O单元组成。用户可以通过硬件描述语言(如VHDL或Verilog)直接定义数字电路的功能,从而实现高度定制化的硬件逻辑。这种“硬件实现”意味着FPGA在执行特定任务时,其操作是直接通过物理电路完成的,无需经过指令解码、调度等软件层开销。相比之下,GPU虽然拥有强大的并行计算能力,但其本质仍是一种通用处理器架构(尽管针对图形和并行计算优化),执行任务时需要经由驱动程序、操作系统和应用程序等多层软件栈,将计算任务映射到成千上万的核心上进行处理。这一过程必然引入额外的延迟,尤其是在处理小批量、高频率的实时数据时,GPU的流水线调度和上下文切换开销会变得尤为明显。

FPGA的并行性是“真正”的硬件并行。在FPGA中,不同的逻辑功能可以同时在不同的硬件资源上执行,且互不干扰,数据流可以以流水线方式在定制化的数据路径中高速流动。例如,一个网络数据包处理逻辑可以在接收数据的同时进行解析、过滤、修改和转发,所有步骤几乎同时发生,延迟仅受限于电路的门延迟和线延迟,通常可达到纳秒级。而GPU的并行性更多体现在数据级并行上,即对大量数据执行相同的操作(SIMD),但对于有复杂依赖关系或需要频繁决策的任务,其线程调度和内存访问延迟(尤其是全局内存访问)会成为瓶颈,延迟通常在微秒级甚至更高。

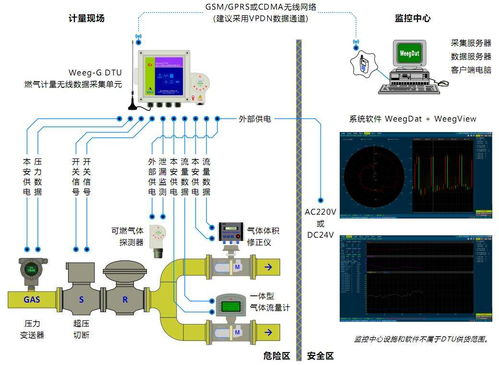

在信息系统集成服务中,延迟往往受到整个系统链路的影响,包括数据采集、处理、传输和响应等多个环节。FPGA能够被集成到数据流的关键路径上,作为专用的硬件加速器或预处理单元。例如,在高速交易系统中,FPGA可以直接与网络接口卡(NIC)耦合,实现网络协议栈的硬件卸载,在数据包到达的瞬间即进行处理和决策,从而将延迟从软件实现的几十微秒降低到亚微秒级别。GPU则通常作为主处理器(CPU)的协处理器,数据需要从网络设备通过总线(如PCIe)传输到GPU内存,处理后再传回,这一过程本身就增加了数微秒的延迟。

FPGA的可重构性为信息系统集成提供了极大的灵活性。在集成了FPGA的系统中,可以根据不同的应用场景快速重新配置硬件逻辑,优化数据路径,从而持续保持最低的延迟。而GPU的架构相对固定,优化主要依赖于软件算法和编程模型的调整,其在延迟上的优化空间存在天花板。

选择FPGA还是GPU,并不仅仅取决于延迟。GPU在浮点运算吞吐量、编程易用性和生态系统方面具有巨大优势,适合训练人工智能模型、大规模科学计算等对吞吐量要求高于延迟的场景。但在那些对延迟极其敏感、需要确定性和可预测响应时间的集成系统中——如自动驾驶的传感器融合、工业控制系统的实时反馈、5G基带的信号处理——FPGA的硬件级低延迟特性使其成为不可替代的选择。

FPGA之所以能比GPU实现低得多的延迟,根源在于其硬件可编程的本质带来了极致的定制化、真正的硬件并行和精简的数据路径,使其能够紧密集成到信息系统的关键链路中,消除软件开销。在信息系统集成服务中,深入理解FPGA的这一优势,有助于为高实时性应用设计和部署更高效、更可靠的解决方案。

如若转载,请注明出处:http://www.sol2017.com/product/44.html

更新时间:2026-02-24 14:45:16